Gemini 3 の発表から約1か月、Google が新たに『Gemini 3 Flash』を公開しました。 一言でいうと、「速い、安い、賢い」モデルとのこと。

先に発表された Gemini 3 Pro / Deep Think が高性能路線だとすると、『Gemini 3 Flash』は 実運用向けの最適解という立ち位置に見えます。

(参照) Google Blog

https://blog.google/intl/ja-jp/company-news/technology/gemini3-flash/

特徴:スピード × コスト × 実用性

Gemini 3 Flash は、Gemini 3 Pro に近い推論性能を保ちつつ、

・低レイテンシ ・高効率(トークン消費が少ない) ・低コスト

を重視して設計されています。

日常的なタスクでは、従来モデルより 約30%少ないトークンで高精度というのは、API利用を前提にするとかなり嬉しいポイントです。

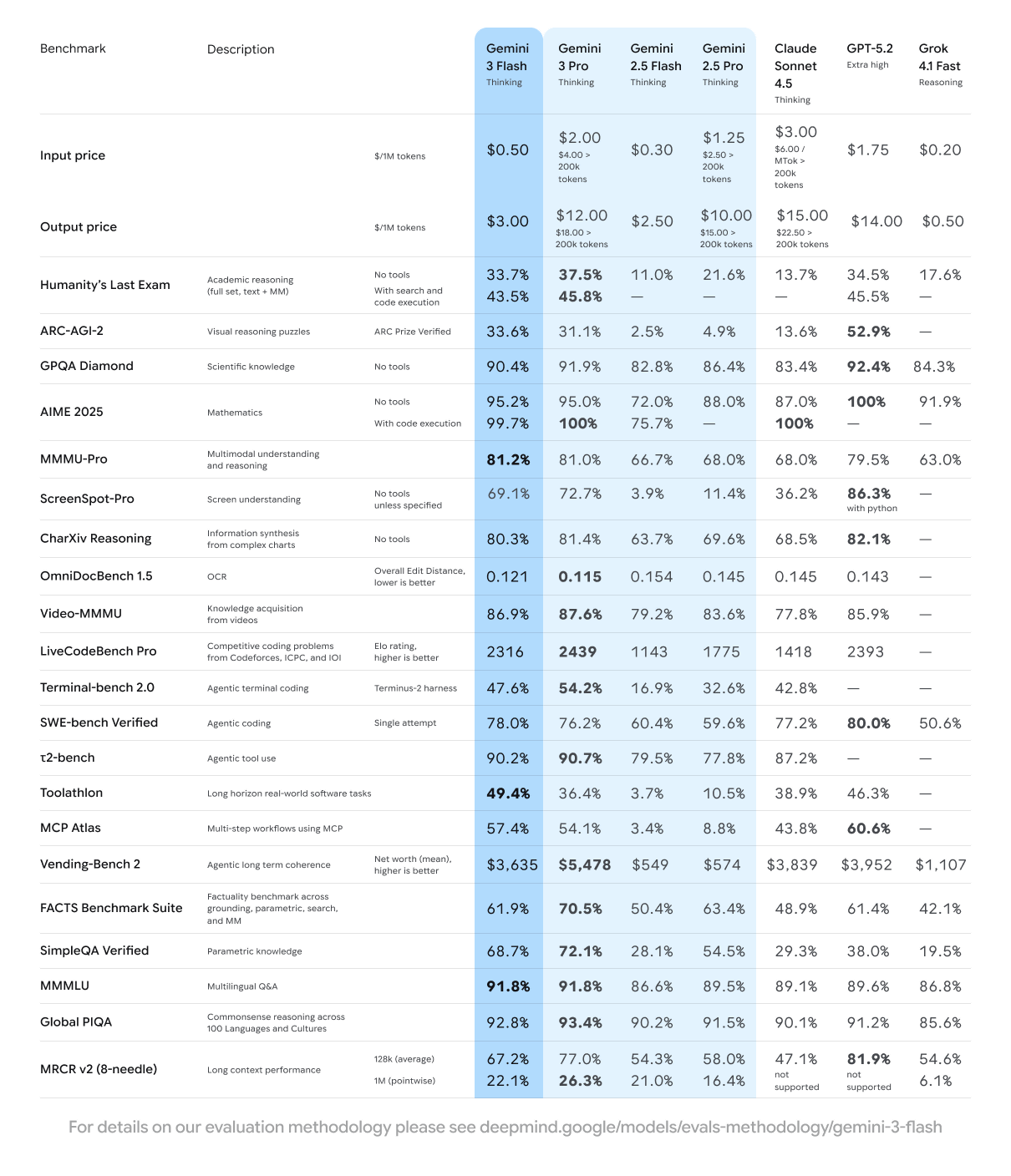

価格も明確で、

入力:100万トークンあたり $0.50

出力:100万トークンあたり $3

と、プロダクト組み込みや大量リクエストでも現実的な水準です。

ベンチマーク:「速さ重視」の枠を超えた性能

ベンチマーク結果を見ると、単なる「軽量モデル」とは言えない実力が見えてきます。

高度な専門知識を問う「Humanity’s Last Exam(HLE)」では、ツール未使用で 33.7% を達成。これは旧モデルの約3倍であり、GPT-5.2の34.5%に迫る水準です。

コーディング能力を測る「SWE-bench Verified」では 78.0%。これは Claude 4.5 の77.2%、さらには上位モデルである Gemini 3 Pro の76.2%をも超えています。

また、一般知識の正確性を測る「SimpleQA Verified」では 68.7% を記録。GPT-5.2 の38.0%、Claude 4.5 の29.3%を大幅に上回っており、回答精度が飛躍的に向上していることが分かります。

技術的な注目点:TPU × JAX × ML Pathways

個人的に興味深いのは、Gemini 3 Flash が Google 独自の TPU 上で、JAX と ML Pathways を用いてトレーニングされている という点です。

(※TPU … Google が開発した機械学習特化チップ。業界標準の NVIDIA GPU と比べ、大規模学習のコストが数分の一で済み、電力効率にも優れます。)

機械学習の学習フェーズでは、NVIDIA の GPU と CUDA を使うのが業界の定説になっています。PyTorch も TensorFlow も、基本的には CUDA ベースで最適化されてきました。

しかし Google は、自社開発の TPUと、それに最適化された独自のソフトウェアスタックで独自路線を進んでいます。

JAX :Google が開発した機械学習ライブラリです。NumPy ライクなシンプルな記述でありながら、XLA コンパイラを通じて TPU/GPU 上で高速実行できるのが特徴です。PyTorch のような「カーネル中心」のアプローチとは異なり、コンパイラがプログラム全体を解析して最適化するため、新しいモデルアーキテクチャでも手書きカーネルなしで高性能を発揮できます。

ML Pathways :大規模分散計算のための統合ランタイムです。研究者は「1台の強力なマシン」を使っているかのようにコードを書けば、Pathways が裏で数万チップにまたがる計算を自動でオーケストレーションしてくれます。Gemini のモデルカードにも、JAX と Pathways の「単一コントローラ」により、単一の Python プロセスでトレーニング全体を制御でき、開発ワークフローが大幅に簡素化されると記載されています。

この垂直統合(TPU ハードウェア + JAX + Pathways)により、Google は他社にはない効率性を実現しているようです。

Gemini 3 Flash の「速くて賢い」という特性も、この技術基盤あってこそと言えるかもしれません。

安全性の向上

安全性面でも進化しています。

Gemini 2.5 Flash と比較して、安全性評価やトーンの客観性が向上。

プロンプトの不当な拒否は10.4%減少したとのことで、実用面でのストレスも軽減されそうです。

コーディング用途との相性

SWE-bench Verified で 78.0% というスコアは、「速さ重視モデル」という枠を超えた結果です。

・エージェントによるコード生成

・A/Bテストや検証ループの高速化

・低遅延が求められる対話型アプリ

こういった用途では、Gemini 3 Flash が力を発揮しそうです。

使える場所について

Gemini 3 Flash はすでに以下で利用可能です。

開発者向け … Google AI Studio、Gemini API、CLI、Vertex AI

一般ユーザー向け … Gemini アプリ、Google 検索の AI Mode

法人向け … Gemini Enterprise

Gemini アプリでは デフォルトモデルにもなっており、無料で次世代モデルを触れるのも大きいですね。

まとめ

Gemini 3 Flash は、

「最高性能」ではない

でも「一番ちょうどいい」

そんなモデルです。

速度・コスト・知能のバランスが良く、実装を前提に選びやすい。そしてその裏には、TPU + JAX + Pathways という Google 独自の技術スタックがあります。

これから Gemini を使ったプロダクトを作るなら、まずは Gemini 3 Flash から試す、という判断はアリかもしれません。

ご一読いただきありがとうございました。

また、別の記事でお会いしましょう。